1. Was ist ein Data Mesh?

Data Mesh bezeichnet einen dezentralisierten Ansatz für die Datenarchitektur, der 2019 von Zhamak Dehghani eingeführt wurde. Statt Daten zentral durch ein einziges Data-Team zu verwalten, setzt Data Mesh auf domänenorientierte Datenverantwortung: Fachbereiche (Domänen) übernehmen die Verantwortung für ihre eigenen Datenprodukte. Wichtige Prinzipien dieses Ansatzes sind: Daten als Produkt (Daten werden mit Produktdenken behandelt: hoher Qualitätsanspruch und Ausrichtung an den Nutzerbedürfnissen), eine Selbstbedienungs-Dateninfrastruktur als Plattform (technische Self-Service-Lösungen, die es Domänenteams ermöglichen, eigenständig mit Daten zu arbeiten), sowie eine föderierte (verteilte) Daten-Governance (ein übergreifender Rahmen von Datenstandards und Richtlinien, der von allen Domänen befolgt wird). Diese vier Kernprinzipien–, domänenorientierte Datenverantwortung, Daten als Produkt, Self-Service-Dateninfrastruktur und föderierte rechnergestützte Governance, bilden das Fundament des Data-Mesh-Paradigmas.

Durch Data Mesh vollzieht sich sowohl ein kultureller als auch ein technischer Wandel in Organisationen. Kulturell bedeutet es, dass bereichsspezifische Experten (Domain-Teams) zu Datenproduzenten werden und End-to-End-Verantwortung für “ihre” Daten übernehmen, von der Erstellung über die Aufbereitung bis zur Bereitstellung dieser Daten als wiederverwendbare Data Products. Dieses Empowerment der Fachbereiche erfordert erhebliche organisatorische Veränderungen, da traditionelle zentrale Strukturen aufgebrochen werden müssen. Technisch wiederum benötigt ein Data Mesh eine robuste, domänenübergreifende Dateninfrastruktur (Plattform), die Self-Service-Funktionen bietet. So eine Datenplattform stellt sicher, dass Teams ihre Datenpipelines und -produkte eigenständig entwickeln können, während globale Standards (etwa für Sicherheit, Qualität und Interoperabilität) gewährleistet bleiben. Im Kern zielt Data Mesh darauf ab, die Engpässe und Silos herkömmlicher zentralistischer Data-Warehouse- oder Data-Lake-Architekturen zu überwinden. Indem diejenigen, die die Daten am besten kennen, die Verantwortung tragen, sollen Daten schneller und in höherer Qualität für unterschiedlichste Zwecke verfügbar gemacht werden. Dies fördert Agilität und Innovation, erfordert aber ein Umdenken: Daten werden nicht mehr als Nebenprodukt betrachtet, sondern als wertschöpfende Produkte mit klarem Nutzenversprechen für interne Datenkonsumenten.

2. Domänenübergreifende Datenprodukte mit CData Virtuality

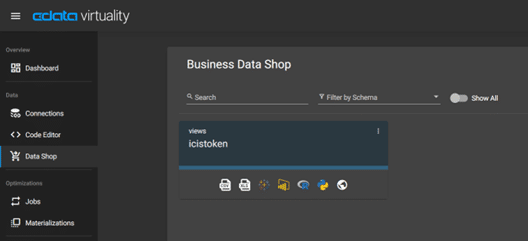

Abb. 1: Business Data Shop in CData Virtuality – zentrale Übersicht virtueller Data Products (Views) aus verschiedenen Domänen, mit Icons für verfügbare Schnittstellen (z.B. SQL, BI-Tools, Excel, Python, R) unter jedem Datenprodukt.

CData Virtuality stellt als Enterprise Data Virtualization Platform eine entscheidende Infrastrukturkomponente dar, um einen Data-Mesh-Ansatz praktisch umzusetzen. Es fungiert als unabhängige semantische Schicht, die vereinheitlichten Live-Datenzugriff, Integration und Governance über Domänengrenzen hinweg ermöglicht. Konkret können Domänenteams mit CData Virtuality aus ihren verteilten Quellsystemen virtuelle Sichten erstellen – also Data Products, die mehrere Datenquellen umfassen können, ohne die Daten physisch zu bewegen. Diese virtuellen Datenprodukte werden dann in einem integrierten Datenmarktplatz (dem Business Data Shop) veröffentlicht, wo sie unternehmensweit auffindbar und teilbar sind.

Im Business Data Shop kann jedes Team seine fertigen Datenprodukte beschreiben und für andere Domänen freigeben. Datenkonsumenten aus anderen Bereichen finden dort einen Katalog aller verfügbaren Data Products und können bei Bedarf Zugriff anfordern oder direkt darauf zugreifen. CData Virtuality unterstützt dabei verschiedene Schnittstellen, damit jede Nutzerrolle die Daten im passenden Tool konsumieren kann: So lässt sich ein Datenprodukt mit einem Klick als Excel- oder CSV-Vorschau öffnen oder direkt in BI-Plattformen wie Tableau und Power BI einbinden; für Data Scientists werden automatisch Code-Snippets in Python oder R bereitgestellt, und auch ein REST/HTTP-Zugriff ist verfügbar. Diese One-Click-Bereitstellung über verschiedenste Kanäle senkt die Eintrittshürde für die Nutzung domänenfremder Daten erheblich. Wichtig ist: Die Daten verbleiben dabei an ihren Ursprungsorten: CData Virtuality greift in Echtzeit darauf zu, anstatt Kopien anzulegen. Dadurch können cross-domain-Analysen durchgeführt werden, ohne klassische ETL-Prozesse für jedes Szenario durchlaufen zu müssen. Gleichzeitig bleibt die globale Daten-Governance konsistent: Das System stellt sicher, dass zentrale Sicherheits- und Qualitätsregeln auch über Domänengrenzen hinweg eingehalten werden. Insgesamt unterstützt CData Virtuality somit die Idee von „Daten als Produkte“ in verteilten Teams, indem es eine gemeinsame Plattform zum Erstellen, Auffinden und Nutzen von Datenprodukten im gesamten Unternehmen bereitstellt.

3. Vorteile von CData Virtuality im Data-Mesh-Kontext

CData Virtuality bietet mehrere konkrete Vorteile, die eine dezentrale Data-Mesh-Architektur erst “real” und praktikabel machen. Insbesondere hervorzuheben sind:

– Zugriff ohne Replikation: Durch die zugrundeliegende Datenvirtualisierung ermöglicht CData Virtuality den Zugriff auf Live-Datenquellen, ohne die Daten aufwändig replizieren oder verschieben zu müssen. Abfragen werden bei Bedarf über diverse Quellen verteilt (federated queries), sodass stets auf aktuelle Daten zugegriffen wird, während redundante Kopien entfallen. Dies vereinfacht die Datenpflege und -governance erheblich und vermeidet Dateninkonsistenzen, da jede Domäne weiterhin die Single Source of Truth für ihre Daten bleibt. Bei Leistungsbedarf können ausgewählte virtuelle Views zwar materialisiert oder zwischengespeichert werden, doch grundsätzlich entfällt der Zwang zu klassischen ETL-Pipelines für jede bereichsübergreifende Auswertung.

– Granulare Rechteverwaltung: CData Virtuality stellt umfangreiche Funktionen bereit, um feingranular zu steuern, wer welche Daten sehen und nutzen darf. So unterstützt die Plattform z.B. Row-Level Security (zeilenweise Zugriffsbeschränkung) und Column-Masking (Ausblenden oder Anonymisieren sensibler Spalten) direkt im semantischen Layer. Unterschiedliche Benutzerrollen können exakt die Ausschnitte der Daten bekommen, für die sie berechtigt sind, was gerade in einem Data Mesh essenziell ist, um Vertrauen und Compliance zu wahren. Zusätzlich lässt sich die Lösung in bestehende Governance- und Identity-Management-Systeme integrieren (etwa Data-Catalog-Tools wie Collibra), um unternehmensweite Richtlinien konsistent durchzusetzen. Durch diese feine Abstufung der Zugriffsrechte können Domänen zwar autonom agieren, unterliegen aber dennoch gemeinsamen Sicherheits- und Datenschutzstandards.

– Rollenbasierte Bereitstellung: Ein weiterer Vorteil ist die benutzerzentrierte Bereitstellung der Datenprodukte für verschiedene Anwendergruppen im Unternehmen. CData Virtuality bietet jeder Rolle die passende Zugriffsmöglichkeit: Fachanwender können über bekannte Tools (BI-Tools, Excel etc.) auf Daten zugreifen, während Entwickler und Data Scientists per API, SQL oder Programmierschnittstellen (Python, R) arbeiten können. Die Plattform generiert z.B. auf Knopfdruck fertige Konnektoren oder Code-Snippets, sodass Data Products leicht in Analyseskripte, Dashboards oder Anwendungen eingebunden werden können. Gleichzeitig sorgt ein zentrales Rechtemodell dafür, dass nur autorisierte Rollen die für sie vorgesehenen Datenprodukte sehen – ein Vertriebsmitarbeiter erhält etwa andere Datensichten als ein Finanzanalyst. Diese rollenbasierte Bereitstellung erhöht die Akzeptanz, da Nutzer mit ihren gewohnten Werkzeugen arbeiten können, und fördert eine breite, sichere Nutzung der Datenprodukte im Self-Service-Modus.

4. Herausforderungen bei der Umsetzung eines Data Mesh

Trotz moderner Plattformen wie CData Virtuality bleibt die Einführung von Data Mesh in der Praxis anspruchsvoll. Insbesondere treten folgende Herausforderungen häufig auf:

– Data Ownership (Datenverantwortung der Domänen) Die klare Zuordnung von Datenverantwortlichkeiten an einzelne Domänen-Teams ist in der Organisation oft schwierig. In einem Data Mesh muss definiert werden, welche Domäne für welchen Datenausschnitt “Owner” ist – unklare oder überschneidende Zuständigkeiten können hier zu Verwirrung führen. Unternehmen berichten, dass die Verlagerung der Datenhoheit auf Fachbereiche erhebliche kulturelle Veränderungen erfordert und initial viel Kommunikation sowie Schulung nötig ist. Ohne eindeutige Ownership drohen Lücken in der Verantwortlichkeit, Doppelarbeit oder Konflikte zwischen Teams, was letztlich die Datenqualität und -nutzung beeinträchtigen kann. Deshalb müssen Rollen wie Data Product Owner oder Domain Owner etabliert und organisatorisch verankert werden, damit jedes Datenprodukt einen klaren “Besitzer” hat.

– Standardisierung: Obwohl Domänen im Data Mesh autonom arbeiten, muss es gemeinsame Standards und Vereinbarungen geben, damit alle Datenprodukte zusammenpassen. Dazu zählen einheitliche Begriffsdefinitionen (z.B. was ist ein “Kunde”?), Datenformate, Schnittstellen und Qualitätsmetriken unternehmensweit. Die Balance zwischen Autonomie und Standardisierung ist eine der größten Governance-Herausforderungen. Wenn einzelne Teams die globalen Standards missachten, besteht die Gefahr, dass neue Datensilos entstehen. Paradoxerweise würde der Mesh-Ansatz dann wieder zu isolierten Inseln führen. Daher sind Mechanismen wie Data Contracts, zentrale Datenkataloge und regelmäßige Domänen-übergreifende Abstimmung nötig, um Interoperabilität sicherzustellen. Die Einrichtung einer föderierten Governance (zentral definierte, lokal umgesetzte Standards) ist komplex, aber notwendig, damit alle Domänen nach denselben Regeln spielen.

– Daten-Governance & -Security: In einem verteilten Datenökosystem die Daten-Governance konsistent durchzuhalten, ist anspruchsvoll. Die Dezentralisierung von Datenhaltung und Datenverarbeitung erschwert es, globale Richtlinien zentral durchzusetzen, etwa für Datenschutz, Zugriffssicherheit oder Compliance. Jedes Team muss zwar eigenverantwortlich Governance-Aufgaben (Datenqualität sichern, Zugriffe kontrollieren, Vorschriften einhalten) übernehmen, doch ohne geeignete Tools und Prozesse kann dies zu Lücken führen. Federated Governance bedeutet, dass es einen zentralen Ordnungsrahmen gibt (z.B. Sicherheitsklassifikationen, Regelwerke für PII-Daten, Lifecycle-Regeln), der von den Domänen konkret angewandt wird. In der Praxis kämpfen Organisationen damit, das richtige Gleichgewicht zwischen zentraler Kontrolle und lokaler Freiheit zu finden. Ungenügende Abstimmung zwischen den Domänen kann zu widersprüchlichen Policies, Sicherheitsrisiken oder Vertrauensproblemen in die Daten führen. Daher sind transparente Governance-Werkzeuge essenziell, etwa gemeinsame Data Catalogs mit eingebetteten Governance-Funktionen, automatisiertes Monitoring von Datenflüssen und Zugriffsrechten, sowie regelmäßige Audits. Nur so lässt sich gewährleisten, dass trotz verteilter Verantwortung alle Datenprodukte den übergreifenden Unternehmens- und Compliance-Standards genügen.

Fazit

Data Mesh verspricht, Datenwertschöpfung auf eine neue Stufe zu heben, indem es technische und organisatorische Silos aufbricht. Mit Plattformen wie CData Virtuality wird dieser Ansatz real und umsetzbar, da sie die notwendigen Infrastruktur-Bausteine für dezentrale Datenprodukte und deren Verwaltung liefern. Allerdings müssen Unternehmen parallel in Kultur, Prozesse und Governance investieren, um die genannten Herausforderungen, von klarer Data Ownership über Standardisierung bis zu Security, zu meistern. Dann kann ein Data Mesh seine Vorteile voll entfalten: schnellere Insights durch domain-getriebene Innovation, flexibler Datenzugriff über Bereichsgrenzen hinweg und insgesamt eine datengetriebenere, agilere Organisation.